在本文中,我们将讨论:

- 什么是数据提取

- 数据提取的类型和来源

- 如何提取数据

- 数据提取如何帮助您的业务

- 最佳数据提取工具

什么是数据提取

数据提取是从信息池中获取目标数据的过程,例如存在于网络上的开源数据。这是使用“ETL”首字母缩写的过程中第一步:

- Extract(提取)

- Transform(转换)

- Load(加载)

一旦收集了目标信息,例如竞争定价和营销数据,就可以将其分析并作为商业智能(BI)在决策过程中使用。这可以由团队领导等利益相关者执行,他们决定在营销活动信息方面进行转变,或者由根据实时竞争对手变化更新价格的算法执行。

数据提取的类型和来源

数据可以来自各种来源,这些来源几乎和获取目标信息所使用的方法一样多。

数据来源类型

数据可以来自内部活动,例如客户保留和流失的统计数据,政府数据库和档案,以及网络。

数字数据来源

从互联网上收集的数据可以分为个人身份信息(PII)以及受密码保护的信息——这两者最好避免收集,因为根据国际数据法规(包括欧洲的《通用数据保护条例》(GDPR)和加利福尼亚州的《消费者隐私法》(CCPA)),这是非法的。这些已经成为行业标准,参与其中对于企业来说既不合法,也不利于消费者。

可以收集并用于商业价值的开源数据包括:

- 社交媒体

- 搜索引擎

- 竞争对手网站

- 讨论论坛

- 政府网站

- 历史档案

- 电商市场

物理数据来源

物理世界每秒钟都在生成数十亿个数据点,包括:

- 医疗记录

- 保险申请和投诉文件

- 抵押/贷款申请

- 销售点(PoS)交易数据

- 由道路上的汽车或商店中的消费者生成的地理位置数据

- 气象数据,包括天气条件和自然现象

数据提取的类型

数据集可以有多种形式,以下是一些最受欢迎的类型:

一:完整数据记录

这通常包含目标网站上的所有数据点。例如,特定电商市场的所有供应商、产品和客户评论。

二:差异数据集

这些数据集会根据自初始收集作业以来已更改或更新的值进行持续更新。这些可能包括价格、社交媒体/员工数量、募集资金等。

三:智能子集

这些数据集使用过滤器来获取非常具体的信息,帮助回答业务问题或指导业务决策。例如,“公司A做错了什么?”和“我们作为一家风险投资公司可以做些什么来增加价值?”相关的数据点可能是千禧一代对公司产品的不满情绪。

四:丰富的数据集

这些数据集比其他数据集更有价值,因为它们融合了来自多个来源的信息,使利益相关者能够更广泛地了解问题。例如,交叉参考来自5个不同网站/讨论论坛的评论/消费者情绪。

如何提取数据

首先,重要的是要了解数据有两个主要类别:

非结构化数据:是最基本/粗糙形式的数据。通常包括重复条目或损坏的文件,并且格式各异。系统和算法很难处理、索引和使用这种形式的数据。

结构化数据:这是数据的“纯净”、“精炼”形式。重复和损坏的文件已被消除,所有数据记录都已转换为统一格式。算法和系统可以很容易地扫描、索引、分析并从这种数据中产生有价值的输出。

如何提取结构化/非结构化数据

提取结构化/非结构化数据的方法有很多,取决于您的技能和资源。例如,如果您有编程技能,可以使用Python创建自定义收集器。或者,您可以使用结构化查询语言(SQL)在关系数据库中组织和查询数据。

对于没有编程技能的业务人员,最好选择完全自动化的网络抓取解决方案,例如Web Scraper API。这是一个自动清理、匹配、合成、处理和结构化非结构化目标数据的工具,然后将其传递给您的团队/系统。此数据已按照您选择的格式(JSON、CSV、HTML或Microsoft Excel)进行结构化,准备好进行分析。

结构化/非结构化数据提取过程

对于有“程序员倾向”的人,请查阅我们的Python网络抓取指南。以下是使用Python提取数据的一般步骤:

- 步骤1:选择您要目标的网址

- 步骤2:确定要收集的数据

- 步骤3:编写代码

- 步骤4:运行代码以提取数据

- 步骤5:将数据存储为所需格式

对于像Web Scraper API这样的自动化工具,过程如下:

- 选择目标网站。

- 选择首选的收集频率和数据格式。

- 将数据传递到您选择的目的地(webhook、电子邮件、Amazon S3、Google Cloud、Microsoft Azure、SFTP或API)。

数据提取如何帮助您的业务

数据提取可以通过多种方式帮助您:

- 发展您的业务 – 例如,通过跟踪Google上的搜索趋势来识别新的用户需求,然后根据这些需求定制报价。

- 更有效地竞争 – 通过了解竞争对手在受众中获得最多吸引力的地方(例如在社交媒体上)以及哪些产品具有最高的转化率,使您能够调整策略。

- 优化营销活动 – 公司可以利用平台的社会情绪,并在活动中纳入响应性信息。

- 投资情报 – 投资公司可以跟踪新闻文章、公众情绪和开源公司财务活动,以更准确地预测某些证券的股市走势。

企业在数据提取方面面临的最大挑战

企业在尝试提取数据时面临的一些最大挑战包括:

- 缺乏技术知识,例如编程和/或缺乏熟练的数据提取劳动力(DevOps/IT/程序员等)。

- 无法构建、购买和维护有效进行实时数据收集操作所需的硬件和软件。

- 无法在时间表上收集、清理、处理和分析数据,以实际帮助创造“实时价值”,使决策者能够根据当前的竞争对手/消费者活动优化活动。

最佳数据提取工具

市面上有很多数据提取工具。有些比其他的更好——相关因素包括数据质量、数据来源、IP地址和同行。您需要非常小心选择与哪个数据提供商合作,确保所购买的是高质量、最新的信息,并且是合法获取的,以确保数据驱动的产品和服务的长期价值。

Bright Data的产品在道德数据收集方面采用行业领先的标准。我们网络中的所有同行都可以选择自行加入或退出,并在其设备参与我们的数据收集网络时获得充分补偿。

我们有一个专门的团队进行实时合规,包括基于代码的预防和技术响应机制。

最后,所有数据收集工作都100%符合国际数据法律,包括《通用数据保护条例》(GDPR)和《加利福尼亚州消费者隐私法》(CCPA)。

行业领先企业最受欢迎的两种工具包括:

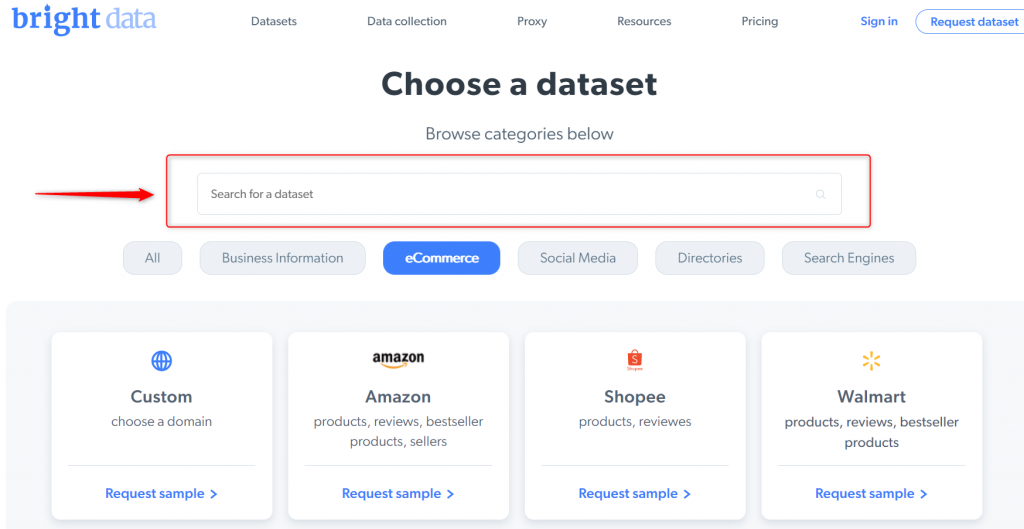

数据集

这些是预先收集的、即用型的数据集,可以在几分钟内订购和获取。您只需选择想要访问的数据集,并将其直接传递给您的团队/算法。

Web Scraper API

Web Scraper API是一种完全自动化的工具,使没有技术知识的业务人员能够无需编码就能获得实时数据流。它清理和合成目标信息,将结构化数据点直接传递给指定的团队和算法。

结论

数据提取是当今大规模数据收集和分析的主要选择,它正在帮助企业和个人改善服务并了解客户/项目期望。虽然无需第三方协助即可完成数据提取,但将过程外包有助于节省时间和资金,以便将其花在更紧迫的业务事务上。